“Terminator, un robot con forma humana programado para tomar decisiones de forma autónoma y causar daño no existe”. Lo segura Reyes Jiménez, profesora de Derecho Internacional Público de la Universidad Pablo de Olavide y doctoranda experta en sistemas de armas autónomas letales (LAWS por sus siglas en inglés) en relación con el Derecho Internacional Humanitario. Jiménez participa en el grupo de Naciones Unidas sobre este armamento, del que forman parte 125 Estados, incluidos los productores de esta tecnología.

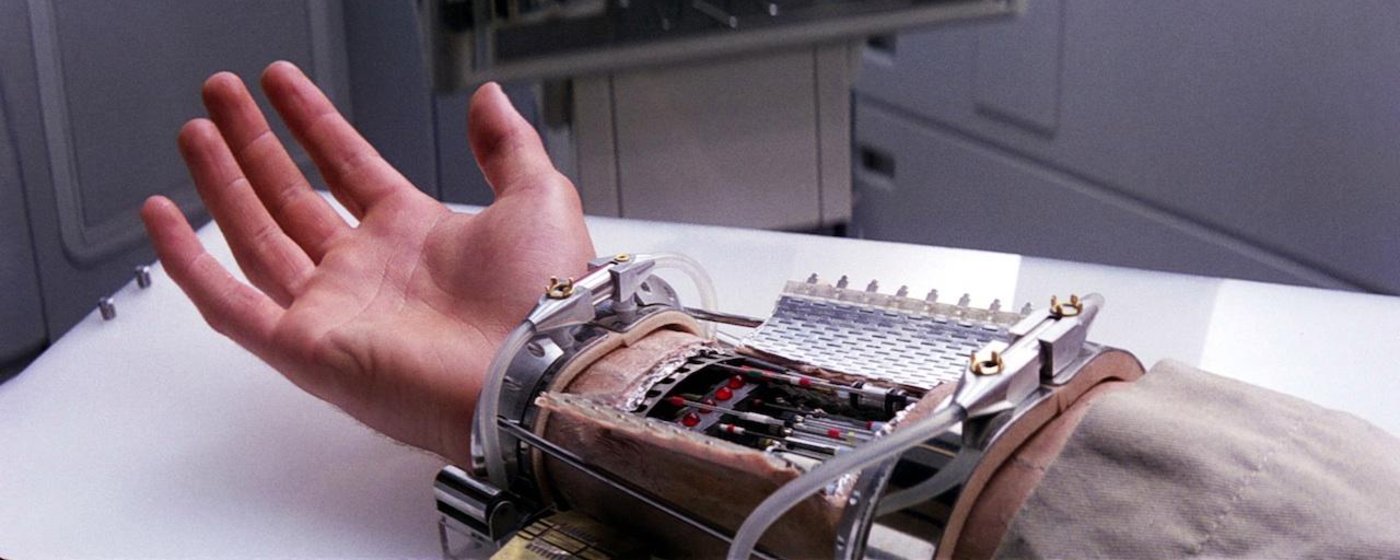

Las armas actuales son máquinas semiautónomas cuyos algoritmos definen su actuación. Pero no improvisan, no matan libremente. Se encuentran sometidas a un control humano, bien dirigidas por control remoto o supervisadas”, advierte Jiménez. Esta circunstancia es clave porque es la base de la futura regulación, si sale adelante. Las funciones críticas frente a un objetivo (detección, selección y disparo) están en manos de personas y así debe seguir.

Uno de los problemas es que el avance tecnológico permita que entre una fase crítica y otra transcurran nanosegundos y el controlador humano no sea capaz de tomar una decisión a tiempo. Israel cuenta con un sistema que permite una secuencia automática entre las fases críticas de 20 segundos, un tiempo escaso para que un experto humano ratifique la amenaza, valore la proporcionalidad de la respuesta y establezca posibles precauciones ante posibles daños ajenos al conflicto, como destruir un colegio o un hospital cercano al objetivo. “Esos principios básicos solo los puede dilucidar un humano y en la reunión internacional hay unanimidad en que esas acciones críticas jamás deben delegarse en la inteligencia artificial”, afirma la profesora.

El último ataque de Estados Unidos, en colaboración con Francia y Reino Unido, sobre Siria con los “bonitos, nuevos e inteligentes” misiles de Trump seguían esos preceptos. La selección de objetivos fue previa, fruto de la información de los servicios de inteligencia, la localización fue programada por los equipos militares y los daños se limitaron a infraestructuras.

En una línea similar se encuentra China. “El impacto de las tecnologías emergentes merecen una discusión plena, objetiva e imparcial. Hasta que esa discusión se complete, no debería haber ninguna premisa o prejuicio que impida el desarrollo de inteligencia artificial”, defiende el gigante asiático en el grupo de la ONU.

Rusia se centra en la responsabilidad de su uso. “No dudamos de la necesidad de mantener el control humano sobre la máquina. La responsabilidad legal debe recaer sobre los Estados y los individuos (…) Ellos deben tomar todos los pasos posibles para prevenir pérdidas, incluyendo las civiles”, relatan los representantes de la federación en el foro de Ginebra.

“La reunión de Naciones Unidas demuestra que, al menos, hay un ánimo negociador y el compromiso es elaborar un informe que propondrá un acuerdo por consenso”, destaca la experta sevillana.

Uno de los miedos del desarrollo de armas tecnológicas autónomas, advierte Jiménez, es la concepción militar de videojuego, donde la distancia sobre las víctimas y la falta de percepción de las consecuencias impida la difícil visión humana de la guerra. Para evitar esta deshumanización, Pascale Fung, de la Universidad de Ciencia y Tecnología de Hong Kong, considera imprescindible la formación en ética del ingeniero robótico. La experta sevillana añade también la importancia de la formación del personal militar encargado de tomar las decisiones críticas. “El ser humano es el responsable”, concluye. En la misma línea se encuentra la Unión Europea.